- 需实现支付密码系统、中间业务平台、超网业务APP、交易系统等业务负载,构建一套满足商业银行技术需求的以双活运行为核心的应用交付体系,以提高业务稳定性,实现业务的可连续性;

- 盘活灾备中心资产,实现双数据中心应用系统同时对外提供服务;

- 内网域名+IP访问共存环境的应用系统双中心灵活调度;

- 提供针对数据库、应用特定的健康检查机制以及更深入探测的自定义健康检查;

-

要确保旧系统内不可改造的业务正常运行。

- 实现灵活的流量分配:如何合理的分配流量,在平衡用户体验的同时避免资源浪费。

- 自动健康检查和故障切换:如何定期的对流量中心进行健康检查,收集数据,发现问题及时进行切换。

- 互相独立:两个中心要尽量独立,实现一个中心故障时,另外一个中心能够自动接管所有业务,避免双中心同时中断,同时在一个中心进行应用维护和升级时不影响日常业务。

由于所有的应用都将在双中心运行,这就要求每个中心的服务资源都能够达到生产环境的100% 支持能力,能提供稳定、可靠的服务。

为解决以上挑战,在方案实施前,神州云科与客户充分沟通,根据客户需求及业务特点,为其量身设计采用神州云科应用交付控制器 YK-ADC 通明湖系列设备进行部署的双活数据中心解决方案。

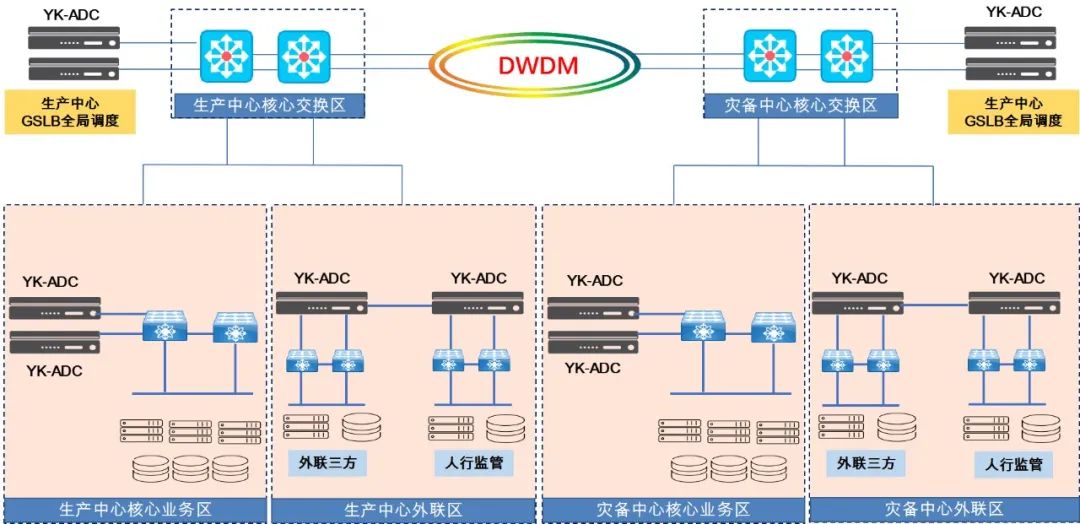

- 生产中心和灾备中心为对称部署,两个中心使用波分技术实现互相连接;

- 在两大中心的业务区域和外联区域部署神州云科负载均衡设备,实现业务跨中心的N+M集群,实现基于IP的应用双中心双活运行;

- 在两大中心的核心交换区域部署神州云科全局调度负载均衡设备,构建双中心的智能DNS解析集群,并同本地负载均衡设备联动,动态感知各中心各应用系统服务状态和服务能力,实现双中心动态解析和智能调度。

2、N+M集群负载均衡

部署两套N+M集群:

- 外联区主要是针对与银联、税务、反欺诈业务等第三方业务的负载;

- 业务区是银行内部的业务如支付系统、超网业务、中间业务、交易系统等负载;

- 四台设备跨中心规划专用心跳交换机实现心跳互联互通,每台设备使用两个接口做LACP链路捆绑与互联的两台堆叠的心跳交换机交叉互联,保障业务的可持续性运行。

3、全局调度负载

- 部署为双中心的全局调度负载,使用GSLB智能DNS解析功能,并与核心业务区域和外联业务区域的SLB进行联动,GSLB实时感知SLB上配置的VS当前的健康状态,并根据预定义的双中心网络拓扑规则以及SLB上VS的实时健康状态决定双中心的解析结果,实现双活的智能调度;

- 同时与ZDNS的设备联动,GSLB将和ZDNS共同构建该商业银行的域名解析体系,ZDNS负责静态域名解析,神州云科GSLB全局调度负责动态域名解析。

该方案具有以下优势:

- 成熟的解决方案,确保数据中心灵活、便捷扩展;

- 在不改动旧系统的情况下,新建一套系统,并且发布于旧系统同样的业务,同时运行;

- 建设全新的GSLB+SLB的联动架构,以SLB的N+M多主结构确保应用发布的高可用。以GSLB确保对流量的调控;

- 对内网将要实行的域名化改造亲和,得益于新旧系统共存,为客户提供足够多的时间去进行由IP到域名的使用习惯改造,并且无负面影响;

- 使用自定义化的健康检查对客户的业务进行精细化探测。

通过部署神州云科应用交付双活数据中心解决方案,客户的基础架构将具备全面的设备灵活性和弹性,可智能分配资源。神州云科可向特定应用、服务或实例分配专用资源,能够支持企业动态管理资源。在确保原有系统及业务正常运营的情况下,将原出口链路负载设备替换为神州云科设备,实现双数据中心应用系统同时对外提供服务,确保内网域名+IP访问共存环境的应用系统双中心灵活调度。同时配置了自定义的健康检查方法,保障业务可持续性。

- 应用级双活数据中心搭建,灵活分配全网业务资源,盘活灾备中心固定资产约8000万;

- 强化灾难恢复预案 (DRP) ,提高恢复时间目标(RTO) 90%以上;

- 基于域名及IP架构的双中心调度,灵活满足不同应用系统双活要求;

- 根据双数据中心不同的处理能力及用户物理位置分布不同,灵活的分配用户请求;

- 可定制的深度健康检查探测技术,实现应用级别的高可用保障。

神州云科提供的定制化解决方案,帮助该商业银行网络设备实现高可用及灵活扩展,进一步提高生产业务的高可用性,满足业务增长的需要,提高用户访问的响应速度,同时也减轻了网站自身系统的性能压力。